每次抓csdn的数据,每抓到1200条数据就报错

来源:14-13 获取和解析详情页 - 2

慕圣3453400

2019-08-21

输入正文

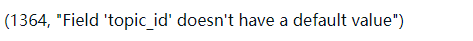

1、开始按照老师写的topic_id作为主键抓取数据存放到mysql数据库,到了1200条的时候就直接报错,pymysql.err.InternalError: (1364, "Field 'topic_id' doesn't have a default value")

我怀疑是遇到了比前一个小的topic_id,才报错

2、之后把topic_id的主键取消,让mysql自动生成id,并且实现自增的方式,还是抓取到1200条数据进行报相同的错误。

麻烦老师指点,谢谢!

写回答

1回答

-

bobby

2019-08-27

这个报错来看你是因为你转到某一个数据的时候这个数据没有topic_id, 导致无法入库。因为列表页可能放了一些链接不是topic的详情页,而是另一个页面的原因导致解析出错,所以你在解析topic_id的地方检查一下是否能提取到值,只有能提取到topic_id的地方才能进行后续逻辑00

这个报错来看你是因为你转到某一个数据的时候这个数据没有topic_id, 导致无法入库。因为列表页可能放了一些链接不是topic的详情页,而是另一个页面的原因导致解析出错,所以你在解析topic_id的地方检查一下是否能提取到值,只有能提取到topic_id的地方才能进行后续逻辑00

相似问题

这个报错来看你是因为你转到某一个数据的时候这个数据没有topic_id, 导致无法入库。因为列表页可能放了一些链接不是topic的详情页,而是另一个页面的原因导致解析出错,所以你在解析topic_id的地方检查一下是否能提取到值,只有能提取到topic_id的地方才能进行后续逻辑

这个报错来看你是因为你转到某一个数据的时候这个数据没有topic_id, 导致无法入库。因为列表页可能放了一些链接不是topic的详情页,而是另一个页面的原因导致解析出错,所以你在解析topic_id的地方检查一下是否能提取到值,只有能提取到topic_id的地方才能进行后续逻辑