老师,为什么有时候点了debug后,直接就INFO: Spider closed (finished)了

来源:4-16 scrapy配置图片下载

慕粉4114369

2019-12-11

老师,为什么有时候点了debug后,直接就INFO: Spider closed (finished)了,而不能像视频这样来debug,而且断点是同个位置,有时候debug能行,有时候就直接INFO: Spider closed (finished)了呢,什么原因呢

2回答

-

慕村9020605

2019-12-26

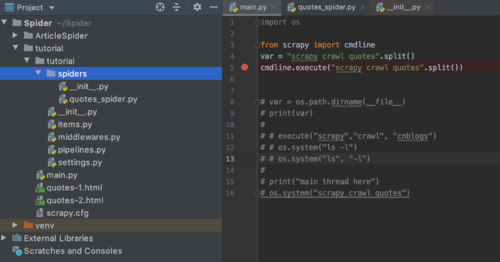

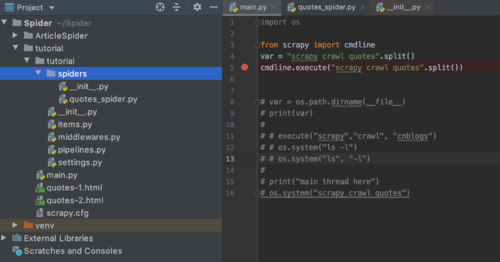

我的是mac,遇到debug无法进入breakpoint的情况:

1、使用cmdline.execute("scrapy crawl quotes")报错

2、使用os.system("scrapy crawl quotes"),程序运转正常,但无法进入quotes_spider.py(cnblogs.py) 文件中parse的方法

3、目前参考 https://stackoverflow.com/questions/21788939/how-to-use-pycharm-to-debug-scrapy-projects ,使用的是 cmdline.execute("scrapy crawl quotes".split()),测试可用,不知道对你是否有帮助

程序结构如下图

其他环境信息:

2019-12-26 14:56:12 [scrapy.utils.log] INFO: Scrapy 1.8.0 started (bot: tutorial)

2019-12-26 14:56:12 [scrapy.utils.log] INFO: Versions: lxml 4.4.2.0, libxml2 2.9.10, cssselect 1.1.0, parsel 1.5.2, w3lib 1.21.0, Twisted 19.10.0, Python 3.7.5 (default, Dec 25 2019, 13:07:13) - [Clang 11.0.0 (clang-1100.0.33.16)], pyOpenSSL 19.1.0 (OpenSSL 1.1.1d 10 Sep 2019), cryptography 2.8, Platform Darwin-19.2.0-x86_64-i386-64bit

00 -

bobby

2019-12-12

这种情况是偶尔出现还是一定会出现?

022019-12-12

相似问题