Scrapy+Redis实现增量爬取,不执行callback函数(Debug模式打断点会执行)

来源:6-17 知乎spider爬虫逻辑的实现以及answer的提取 - 1

慕尼黑7546459

2020-01-03

老师,如题。

按照之前请教过您的方案,尝试通过Redis的 pub/sub实现增量爬虫,执行时,发现yield Request()后没执行正常去callback函数。

但是在debug模式下打来断点,就能正常进入,请老师帮忙分析下

代码如下:

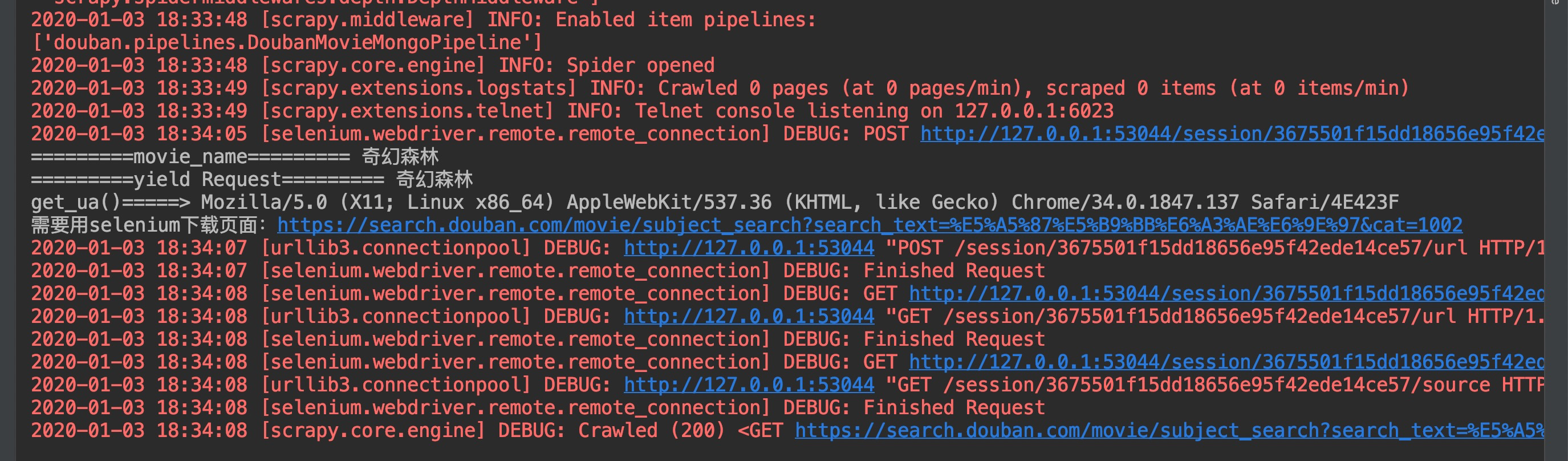

日志如下:

日志在如截图的那里,感觉就卡住了,正常解析的话,还有很多日志的。

PS: 尝试在for循环中sleep,也没用

写回答

1回答

-

bobby

2020-01-05

你如果是通过脚本放入到redis中的脚本不一定会在start_requests中获取到,也有可能是放到parse函数的逻辑中出现,你再parse函数中也打印一个日志看看

062020-01-15

相似问题

scrapy-redis怎么做增量爬取

回答 1