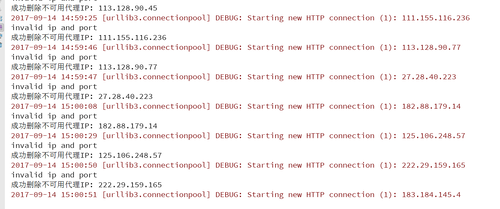

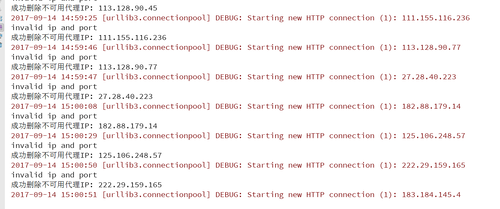

请求百度验证IP是否可用,一直有exception 截屏

来源:8-8 scrapy实现ip代理池 - 3

SingleVergil

2017-09-14

debug 运行了几次都是 invalid ip and port 感觉代码没有问题,好像请求百度是不是失败了?

5回答

-

慕雪8012440

2018-02-26

这样改即可。

10 -

SingleVergil

提问者

2017-09-14

好多IP都是不可用的 这是正常的吗 ? 我都怀疑是不是 这块代码写的有问题

http_url = 'http://www.baidu.com/' # https???????????? http?https?

proxy_url = 'http://{0}:{1}'.format(proxy_ip, proxy_ip_port) # https://{0}:{1}

try{

proxy_dict = {

'http': proxy_url,

}

response = requests.get(http_url, proxies=proxy_dict)

print('请求百度验证IP返回成功')except .....

012017-09-15 -

SingleVergil

提问者

2017-09-14

视频中 def judge_ip(self, proxy_ip, proxy_ip_port):

#判断ip是否可用 访问百度查看IP是否可用

http_url = 'http://www.baidu.com/' # http

proxy_url = 'http://{0}:{1}'.format(proxy_ip, proxy_ip_port)结果验证了好多都是失败的 是不是我写的代码有问题

最后改成

def judge_ip(self, proxy_ip, proxy_ip_port):

http_url = 'https://www.baidu.com/' # http

proxy_url = 'https://{0}:{1}'.format(proxy_ip, proxy_ip_port)然后随机验证了几个都是 返回200 debug没有exception

我现在有点晕了:就是到底是验证某个IP就应该不可用,还是说我的代码有我问题 嗯

012017-09-15 -

SingleVergil

提问者

2017-09-14

为什么 http_url = 'http://www.baidu.com/'

改成 http_url = 'https://www.baidu.com/'http--->https 就正常了 scrap 是不是http https 都支持? 这里有点疑问 老师!

012017-09-14 -

SingleVergil

提问者

2017-09-14

为什么 http_url = 'http://www.baidu.com/'

改成 http_url = 'https://www.baidu.com/'http--->https 就正常了 scrap 是不是http https 都支持? 这里有点疑问 老师!

012017-09-15

相似问题