fit数据是dataset,同时loss函数又用到dataset的数据和imagedata网络输出preds的数据计算

来源:4-8 tf.data读取tfrecord文件并与tf.keras结合使用

O_O_似水流年_O_O

2020-03-03

老师,我现在碰到一个问题

我在用tensorflow2实现psenet算法的时候,gt.txt文件会被处理成N个example字段,当然这些字段有一个是imagedata的数据,然后会将imagedata输入到网络中,前向运算得到(Batch, 512, 512, 4)的数据,也就是preds。但是我的loss计算需要用到preds的数据,同时还需要example里面其他字段的数据,比如原始检测框点的坐标,trainingmask的信息等。

对于这样的数据在老版本中是自定义一个generator,然后next得到example的所有数据,然后将imagedata数据输入到网络中,得到preds数据,然后自定义一个loss函数,将这些数据进行计算loss,然后计算梯度。

但是在新版本中直接fit喂数据了,第一个疑问,我以什么样的形式将imagedata输入给网络。第二个疑问,imagedata输入网络得到的preds数据,如何跟原始gt数据送给loss函数进行计算。对于这个疑问我不知道该怎么写代码,思路我能懂

2回答

-

正十七

2020-03-05

同学你好,你的这个问题其实我们在后面第十章的大项目中有类似的代码,在tensorflow2.0中除了fit函数外,我们也可以自己定制这个学习过程。

这是第十章seq2seq+attn的训练的实现,这里就是遍历dataset,然后把batch塞给网络

EPOCHS = 10 for epoch in range(EPOCHS): start = time.time() encoding_hidden = encoder.initialize_hidden_state() total_loss = 0 for (batch, (inp, targ)) in enumerate(dataset.take(steps_per_epoch)): batch_loss = train_step(inp, targ, encoding_hidden) total_loss += batch_loss if batch % 100 == 0: print('Epoch {} Batch {} Loss {:.4f}'.format(epoch + 1, batch, batch_loss.numpy())) # saving (checkpoint) the model every 2 epochs if (epoch + 1) % 2 == 0: checkpoint.save(file_prefix = checkpoint_prefix) print('Epoch {} Loss {:.4f}'.format(epoch + 1, total_loss / steps_per_epoch)) print('Time taken for 1 epoch {} sec\n'.format(time.time() - start))train_step的实现则如下:

@tf.function def train_step(inp, targ, encoding_hidden): loss = 0 with tf.GradientTape() as tape: encoding_output, encoding_hidden = encoder(inp, encoding_hidden) decoding_hidden = encoding_hidden decoding_input = tf.expand_dims([targ_lang.word_index['<start>']] * BATCH_SIZE, 1) # Teacher forcing - feeding the target as the next input for t in range(1, targ.shape[1]): # passing enc_output to the decoder predictions, decoding_hidden, _ = decoder(decoding_input, decoding_hidden, encoding_output) loss += loss_function(targ[:, t], predictions) # using teacher forcing decoding_input = tf.expand_dims(targ[:, t], 1) batch_loss = (loss / int(targ.shape[1])) variables = encoder.trainable_variables + decoder.trainable_variables gradients = tape.gradient(loss, variables) optimizer.apply_gradients(zip(gradients, variables)) return batch_loss

在这里,数据输入给网络后,就可以通过loss_function来实现损失,这个时候,你就可以按照你自己的需求自定义损失的实现。

012020-03-05 -

O_O_似水流年_O_O

提问者

2020-03-03

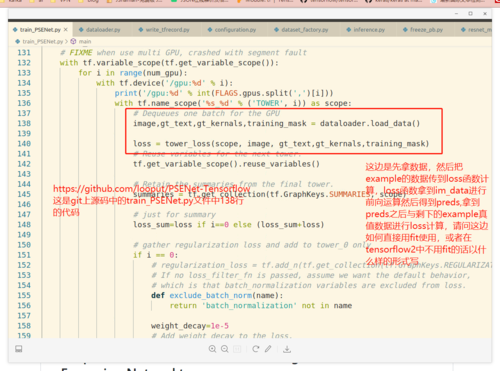

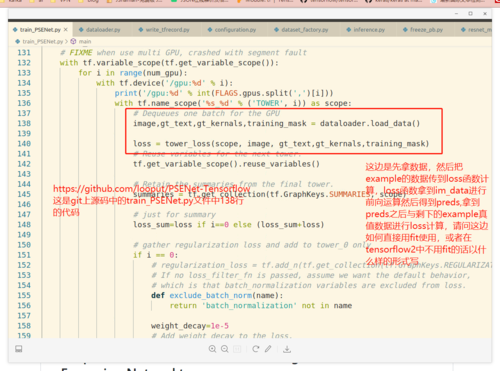

老师最好能给一小段代码,或者案例代码,我只要看明白tensorflow2是如何操作这样的逻辑即可,就是looput/psenet tensorflow源码中trainpsenet里面那一段,

00

00

相似问题